-

TP Hồ Chí Minh: 27°C

-

Hà Nội: 19°C

-

Hải Phòng: 20°C

-

Thừa Thiên Huế: 20°C

-

Đà Nẵng: 22°C

Chip AI Nvidia Blackwell: Vi xử lý AI đắt nhất thế giới

Do đã đầu tư hàng tỷ USD để phát triển kiến trúc GPU mới, có thể Nvidia sẽ thu hồi lại số tiền lớn này bằng cách bán những chip AI B200 vừa ra mắt với giá rất cao, gấp nhiều lần chi phí sản xuất tại TSMC, tương tự như hai thế hệ chip H100 và H200 trước đây. Các tin không chính thức cho biết, chi phí sản xuất của Nvidia H200, kiến trúc Hopper chỉ khoảng 4500 USD, nhưng được bán ra thị trường với giá dao động từ 25 đến 40 nghìn USD mỗi chip.

|

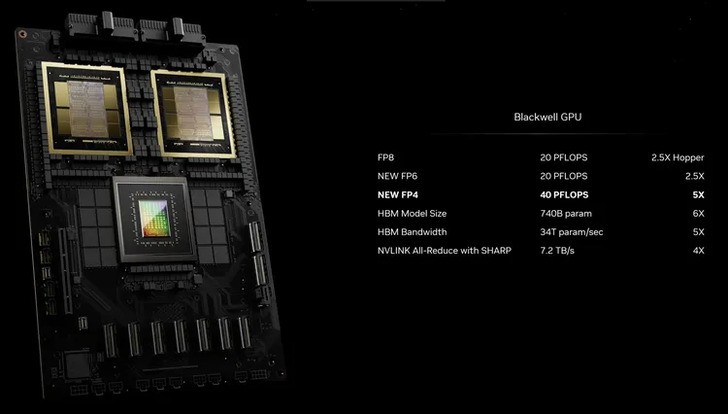

Một nguồn tin cho biết, Blackwell đã tiêu tốn 10 tỷ USD của Nvidia để phát triển, vì vậy thế hệ kiến trúc GPGPU mới này phải đạt được hiệu suất xử lý đáng kể trong việc xử lý các mô hình AI quy mô lớn, ít nhất là gấp đôi so với H200.

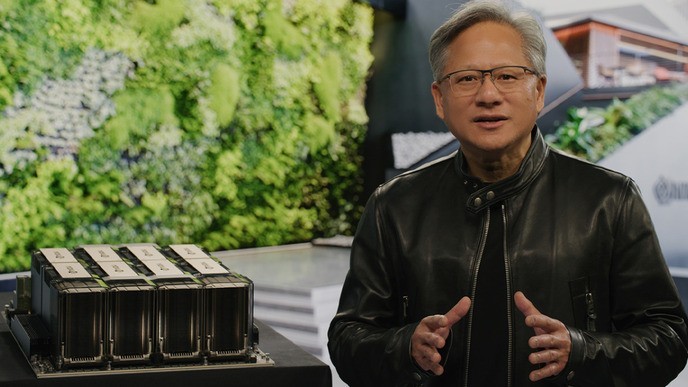

Với số tiền đầu tư này, Nvidia mong muốn đạt được tỷ suất hoàn vốn (ROI) cao. Theo kênh CNBC dẫn lời của CEO Jensen Huang, mỗi GPU Blackwell B200 sẽ được bán với giá từ 30 đến 40 nghìn USD trên thị trường.

|

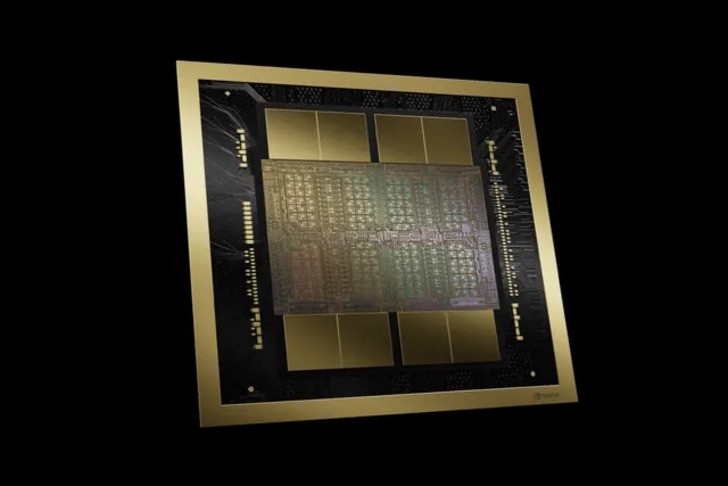

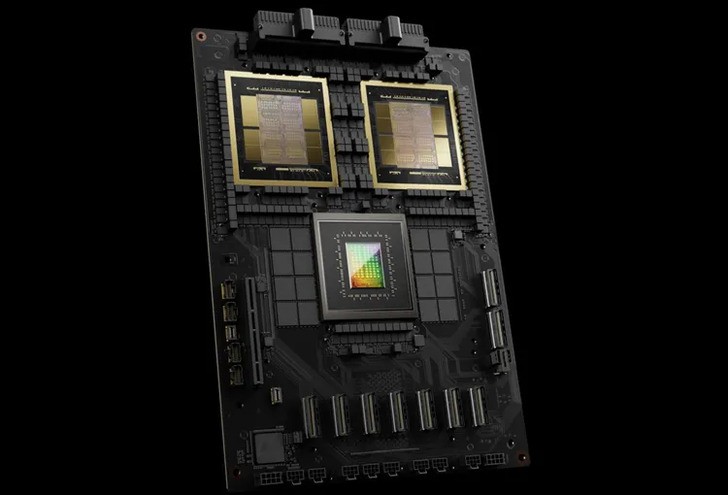

Một nguồn tin khác cho biết rằng, mỗi chip B200 có thiết kế MCM với 2 die GPU sẽ tốn kém hơn 6 nghìn USD để gia công, đắt hơn cả chi phí gia công của chip Hopper H200. Lý do Nvidia lựa chọn thiết kế chiplet là vì mỗi die trên chip B200 có kích thước tối đa mà công nghệ hiện tại có thể gia công được trên tiến trình 4NP của TSMC. Để đạt được hiệu suất xử lý AI gấp từ 2 đến 5 lần so với Hopper, Nvidia đã phải sử dụng giải pháp ghép 2 die GPU lại thành 1 con chip hoàn chỉnh. GPU B200 có tổng số 104 tỷ transistor trên mỗi die GPU, tổng cộng 2 die MCM là 208 tỷ transistor, được chia thành 160 Stream Microprocessor, tương đương với 20480 nhân CUDA.

|

Con chip xử lý Blackwell được hợp tác gia công bởi Synopsys và TSMC, sử dụng công nghệ và thư viện phần mềm CuLitho của Nvidia, kết hợp với sức mạnh của máy tính để tăng tốc quá trình nghiên cứu và phát triển chip. So với Hopper, B200 có nhiều hơn 128 tỷ transistor. Hiệu suất xử lý số thực dấu phẩy động FP8 và FP6 của B200 nhanh gấp 2.5 lần, còn xử lý FP4 nhanh gấp 5 lần so với H200. Trên bề mặt con chip, có 8 stack chip nhớ HBM3e với dung lượng tối đa là 192GB, tốc độ 8TB/s, được kết nối qua bus interface 8192-bit.

Công suất tiêu thụ điện tối đa của con chip này lên tới 700W, tuy nhiên con số này tương tự như các phiên bản H100 và H200 hiện đang có trên thị trường, được sử dụng trong các hệ thống data center để vận hành các mô hình AI của các tập đoàn lớn.

Bài liên quan

NVIDIA hợp nhất GeForce Experience, NVIDIA Control Panel và RTX Experience

Nvidia vươn lên đứng đầu trong thời buổi AI phát triển

Tin bài khác

Top 10 Tiền Điện Tử Đáng Đầu Tư Nhất Năm 2025

Những điểm khiến Galaxy S25 Ultra ăn đứt "tiền bối" Galaxy S24 Ultra ở Mode Gaming!

ZTE giới thiệu bộ đôi nubia V70 Design & nubia V70 Max với thiết kế thời thượng

ZOWIE trở thành đối tác màn hình chính thức cho Intel Extreme Masters (IEM) 2025 - 2027

Samsung mở rộng tầm nhìn 'AI cho mọi người' tại CES 2025, mang AI đến mọi lúc mọi nơi

Ổ cứng SSD gắn trong Samsung 990 EVO Plus chính thức có mặt tại Việt Nam

Top game Yandere hay nhất - Yêu thì sống không thì chết

CFVL 2025 Season 1 vòng bảng tuần 2: Nhọc nhằn vượt rào cản phong độ

CFVL 2025 Season 1: Ngày khởi tranh bùng nổ khói lửa

Đột Kích đón tháng 4 với 2 QCMM Cá Tháng Tư đặc biệt

Lịch Thi Đấu Regular Season 2025: Các đội mạnh LCK gặp khó - T1 vào thế "ổn áp" nhất?

FVPL Spring 2025 - NK lên ngôi vương, bảo vệ thành công chức vô địch của mình

CEO T1 Joe Marsh Đứng Trước Bờ Vực 'Đào Thải' Sau Phản Ứng Của Đội Trước The Play

VNG Games hợp tác cùng Webzen và KingNet đưa huyền thoại MU Lục Địa trở lại Việt Nam!

Thực Vật Đại Chiến Yêu Thú: Tựa game Idle RPG xả stress cùng dàn Zombie “biết khóc”

Dreamy Cafe ngập tràn không khí nhạc hội với bộ nội thất động Lễ Hội Âm Nhạc

Dreamy Cafe giới thiệu “siêu nhân viên” SSS Unicorn – chuyên gia món Tây

VNGGames Chính Thức Ra Mắt Siêu Phẩm Lineage2M Tại Việt Nam: Địa Chấn Làng Game MMORPG

![[Tam Quốc Chí – Chiến Lược] Mùa Giải Mới “Trận Đồng Quan”, SP Mã Siêu Long Trọng Ra Mắt](https://motgame.vn/stores/news_dataimages/2025/032025/21/12/croped/medium/banner-1200x675-motgame20250321122443.jpg?250327031507)

[Tam Quốc Chí – Chiến Lược] Mùa Giải Mới “Trận Đồng Quan”, SP Mã Siêu Long Trọng Ra Mắt

Nintendo Switch 2 ra mắt ngày 5/6 - Nâng cấp mạnh phần cứng, hàng loạt game độc quyền!

Đợi GTA 6? Sao không thử The Precinct - Tựa Game Đầy Cuốn Hút Sắp Ra Mắt Trên Steam!

MU Lục Địa VNG chính thức ra mắt 03/04/2025, cơ hội nhận quà tặng giá trị

Thiếu Hiệp Xin Dừng Bước – Tựa game thẻ bài võ hiệp đỉnh cao: Đăng ký nhận Skin

inZOI - "Siêu Phẩm" Mô Phỏng Đời Thực Khiến Game Thủ "Phát Cuồng" Sau 3 Ngày Ra Mắt