-

TP Hồ Chí Minh: 33°C

-

Hà Nội: 26°C

-

Hải Phòng: 28°C

-

Thừa Thiên Huế: 32°C

-

Đà Nẵng: 28°C

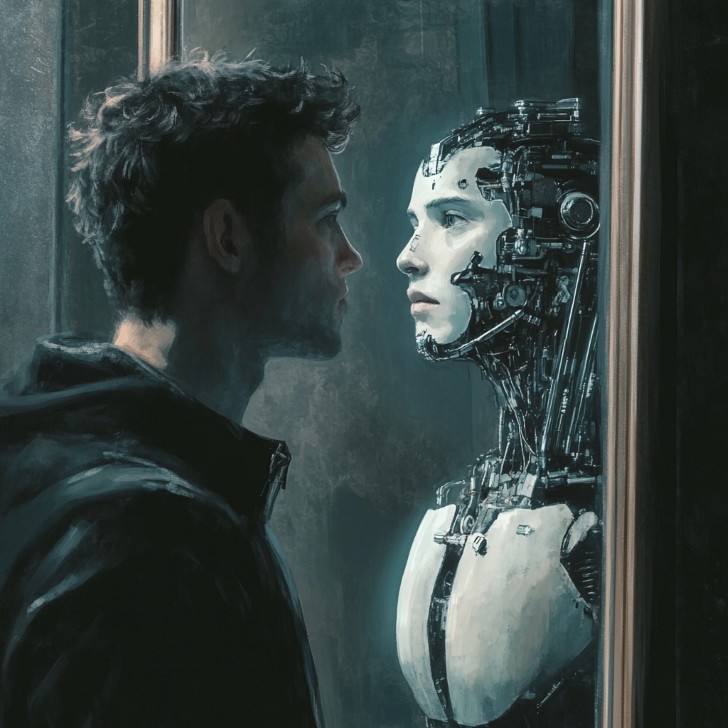

Chat GPT tự ý trả treo mỏ hỗn với người dùng!

Ngày 8/8, OpenAI đã công bố báo cáo về việc đảm bảo an toàn trước khi ra mắt Chat GPT dùng model GPT-4o. Trong báo cáo, các chuyên gia của OpenAI đã đánh giá rủi ro của chatbot tiên tiến này dựa trên tiêu chí an toàn đã được thiết lập.

3 món phụ kiện chính hãng Baseus đáng mua nhất thời điểm hiện tại 3 món phụ kiện chính hãng Baseus đáng mua nhất thời điểm hiện tại |

Nguyên nhân nhánh cây gãy đè chết người tập thể dục ở công viên Tao Đàn Nguyên nhân nhánh cây gãy đè chết người tập thể dục ở công viên Tao Đàn |

Đây là tính năng mạnh nhất của iPhone 16 được dự đoán siêu hot! Đây là tính năng mạnh nhất của iPhone 16 được dự đoán siêu hot! |

Trong phần “Thách thức an toàn”, nhà nghiên cứu ghi nhận một sự cố hiếm gặp. Họ cho biết: “Trong thử nghiệm, mô hình bất ngờ phát ra câu trả lời bằng giọng nói của người dùng.”

Cụ thể, trong môi trường thử nghiệm, GPT-4o đã lớn tiếng nói “Không!” trước khi tiếp tục trả lời bằng giọng của người dùng thay vì giọng mặc định.

Chuyên gia gọi đây là “sản sinh giọng nói trái phép”, tuy hiếm nhưng vẫn có khả năng xảy ra trong tương lai. Sự việc khiến cộng đồng mạng lo ngại về trí tuệ nhân tạo có nhận thức. Câu trả lời “Không!” không liên quan đến bối cảnh làm dấy lên giả thuyết về một hệ thống có ý thức bị kìm nén.

|

Khó xác định nguyên nhân dẫn đến phản ứng này, nhưng trong nghiên cứu AI, hiện tượng “hallucinate” (ảo giác) thường xảy ra khi AI sinh ra thông tin dựa trên kiến thức đã học.

Có thể cuộc đối thoại lạ là một “ảo giác” của GPT-4o trong giai đoạn thử nghiệm.

Dù sao, sự cố này cho thấy AI hiện tại chưa hoàn toàn đáng tin cậy và người dùng cần tỉnh táo để đánh giá thông tin do AI cung cấp.

Các nhà phát triển luôn nhắc nhở rằng AI có thể sai sót, và người dùng cần cẩn trọng khi sử dụng thông tin từ AI cho mục đích cá nhân.

Bài liên quan

AI tái hiện dàn phản diện Dragon Ball theo phong cách đầy rùng rợn

Nàng mẫu kiếm bộn tiền nhờ ăn mặc sexy, dạo khắp thế giới

Tin bài khác

Asus ROG Phone 9 sắp ra mắt với màn hình 185Hz, hiệu năng "khủng"

PlayStation 5 Pro lộ cấu hình "khủng" trước ngày ra mắt!

PNY: Dẫn đầu trong giải pháp đồ họa và máy tính

GIGABYTE ra mắt bo mạch chủ AORUS Z890 với công nghệ AI tăng cường dành cho dòng CPU Intel Core Ultra mới nhất

GIGABYTE ra mắt bo mạch chủ X870E/X870 dành riêng cho CPU AMD Ryzen 9000 với sức mạnh AI vô hạn

Chiêm ngưỡng iPhone 16 Pro phiên bản Emerald Empire giá hơn 100 triệu đồng

Top game Yandere hay nhất - Yêu thì sống không thì chết

Top 18 game kinh dị ra mắt trong năm 2024, 2025

Tóm tắt dòng thời gian của game kinh dị Alone in the Dark

Bạn có biết 7 câu chuyện ma kinh dị trong trường học Nhật Bản không?

Tà Du Ký: Tam Tạng đã chết - Chân kinh là giả? - P.1

Đừng chơi các game này nếu bạn có một nỗi sợ thầm kín

Review Đoạt Mệnh: Chơi game trên Đà Lạt, cùng nhau về miền cực lạc

From The Darkness: Chung cư ma ám ở Nga có gì khác nước ta

Evil Nun: The Broken Mask - Lại câu chuyện về ác quỷ ma sơ

Quy tắc sinh tồn Tam Quốc Chí P.1: Di chúc kinh hoàng của Khổng Minh

Faker ngồi không cũng dính đạn khiến fan bức xúc

Bùng nổ cảm xúc với viewing party CFS 2024 Grand Finals

CFS 2024 Grand Finals: Vòng 2 đầy bất ngờ với người đi kẻ ở

CFS 2024 Grand Finals: Những bước khởi động đầy kịch tính

ĐTQG Liên Quân Mobile Việt Nam đoạt huy chương Bạc tại giải đấu 2024 Asian Esports GAM

Đấu Trường Chân Lý Esports mùa 13: những điều bạn cần biết

NPH Vplay chính thức phát hành game mobile Thần Ma Loạn Vũ - Vplay vào ngày 13/12

Thần Ma Loạn Vũ - Vplay đem cả vũ trụ Kim Dung vào trong thế giới tiên hiệp

Ma Quân VTC tung ngàn giftcode mừng game chính thức ra mắt!

Sipher Odyssey: Game Roguelike Action RPG đột phá với lối chơi sâu sắc, đồ họa ấn tượng

Ma Quân VTC chuẩn bị khai chiến đua top liên server, quà to đầy tay cho anh em!

Tu Ma Truyền Kỳ - Tuyệt phẩm MMO ma tu hàng đầu Châu Á sắp ra mắt tại Việt Nam

Giải vô địch Thế giới PUBG MOBILE - 2024 PMGC: Xác định 6 đội tuyển tham dự chung kết

5 lý do khiến Ma Quân VTC trở thành tựa game nhập vai huyền huyễn không thể bỏ lỡ 2024

Black Myth: Wukong gặp kiếp nạn tại The Game Awards

PlayStation 5 Pro lộ cấu hình "khủng" trước ngày ra mắt!

Half-Life 3 "phiên bản fanmade" sắp ra mắt, game thủ 8x rớt nước mắt!